A deep dive into the abyss of neural networks

Von der Vollautomatisierung und dem Ende der Arbeit bis hin zur Wachablösung der Menschheit durch eine künstliche allgemeine Intelligenz werden die Heilsversprechen und Drohkulissen, die mit dieser Technologie verbunden sind, durch jede Innovation wie etwa Large Language Models (LLMs) auf Neue entfacht. Entgegen dieser Hysterie und des Hypes wird das Seminar eine nüchterne Einführung in die kritischen KI Studien bieten, die es den Studierenden erlauben wird diese Schlüsseltechnologie der Gegenwart und ihre Auswirkungen auf die Gesellschaft besser zu verstehen.

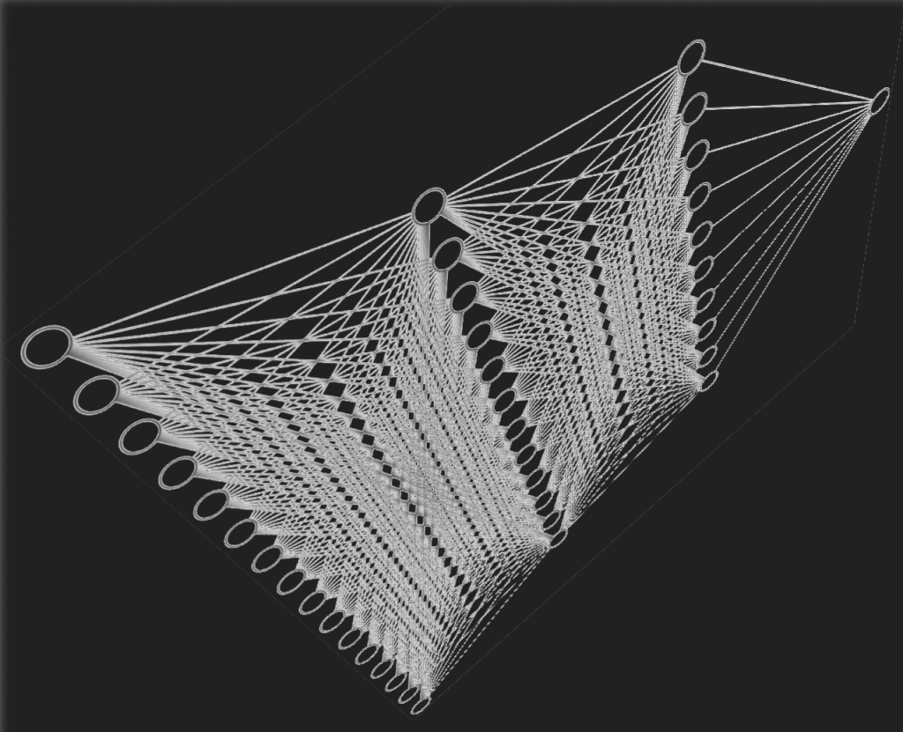

Dazu werden wir uns gemeinsam im ersten Teil des Seminars ein Grundverständnis erarbeiten von dem was heute als Künstliche Intelligenz verhandelt wird. Beginnen werden wir mit einer Einführung in die grundlegende Funktionsweise von neuralen Netzen und dem maschinellen Lernen. Weiter werden wir uns mit der Generierung von Trainingsdaten auseinandersetzen. Dabei werden wir insbesondere Clickarbeit und Datenextraktion wie das web scraping kritisch analysieren. Weiter werden wir uns Schlüsselbegriffe wie bias aneignen, um besser verstehen zu können welche soziale Auswirkungen diese Technologie mit sich bringt. Im zweiten Teil werden wir uns mit Fallbeispielen und Anwendungsfeldern wie etwa Klassifikationsalgorithmen befassen, die eine Gesichtserkennung ermöglichen und bereits heute in Überwachungssysteme wie dem chinesischen Social Credit System eingebettet sind. Abschließend werden wir uns mit generativen KI Modellen wie ChatGPT auseinandersetzen, die in der Lage sind organische Texte, Bilder und Klänge zu generieren, die das Herzstück des bürgerlichen Selbstverständnisses in Frage stellen. Neben der Frage nach Urheberschaft, Wertschöpfung und der Zukunft der Arbeit, drängen sich dabei vor allem auch Probleme eines postfaktischen Zeitalters auf in der sich die Öffentlichkeit zunehmend der Herausforderung gegenüber sehen wird organische Informationen von deep fakes zu unterscheiden.

2. Session 26.10.23 - Historical Roots of Neural Networks

- Mitchell M (2019) Artificial Intelligence: A Guide for Thinking Humans: 1 - 36

- Russel R, Norvig P & Davis E (2010) Artificial Intelligence a Modern Approach: 16-27

Further Reading

- Pasquinelli M (2023) The Eye of the Master. Verso, London.

3. Session 2.11.23 - ImageNet & The Ascent of Machine Learning

- Mitchell M (2019) Artificial Intelligence: A Guide for Thinking Humans: 67-107

- Mitchell M (2019) Artificial Intelligence: A Guide for Thinking Humans: 37-64

Videos on Convolutional Neural Networks by Computerophile

- How Blurs & Filters Work

- CNN: Convolutional Neural Networks Explained

- Finding the Edges (Sobel Operator)

4. Session 9.11.23 - What is a Deep Learning Model?

- O’Neil C (2016) Weapons of Math Destruction: 15 -31

- Video Series "Neural Networks" (vier Videos ~60min.) by 3Blue1Brown

5. Session: 16.11.23 - Discriminative and Generative Models

- Wolfram S (2023) What Is ChatGPT Doing … and Why Does It Work?

6. Session 23.11.23 - Data I: Social Domination and Data

- Chun W (2021) Discriminating Data: Correlation, Neighborhoods, and the New Politics of Recognition. MIT Press: 35-74

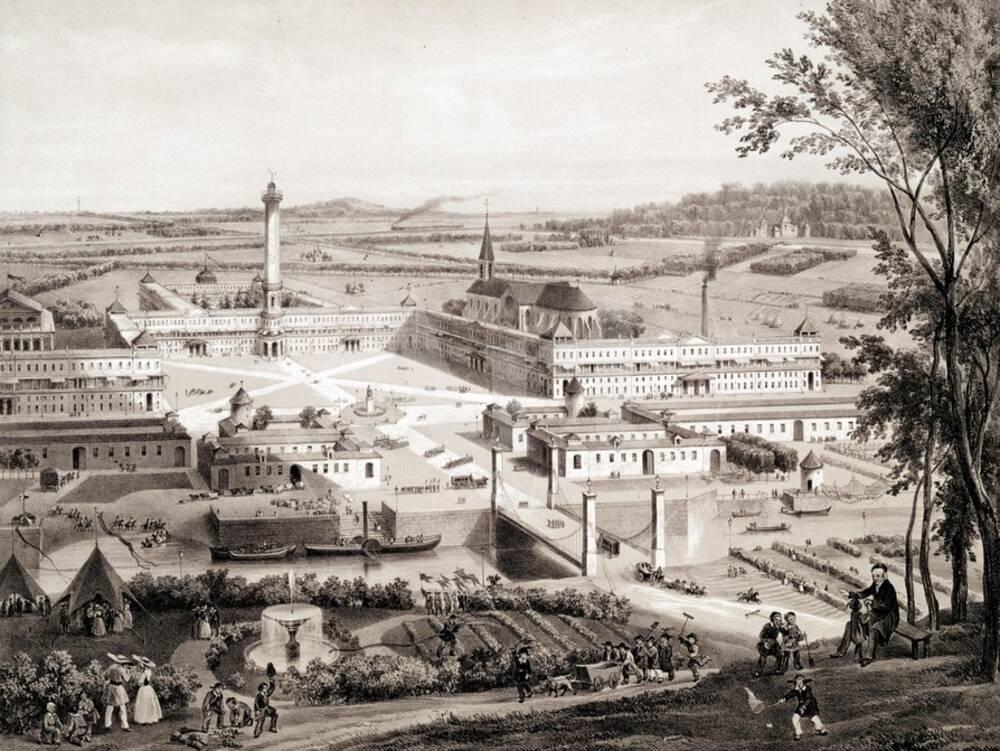

- Whittaker M (2023) Origin Stories: Plantations, Computers, and Industrial Control. Logic(s) Magazine.

7. Session 30.11.23 - Data II: Datasets and Datacenters

- Noorden R (2002) The ethical questions that haunt facial-recognition research. Nature, 587(7834), pp.354-359.

- Evgeny Morozov (2015) Socialize the Data Centres! New Left Review (91). p. 63 - 66

- Metz C and Hill K (2021) Here’s a Way to Learn if Facial Recognition Systems Used Your Photos. New York Times

- Harvey A (2021) Exposing AI

8. Session 7.12.23 - Data III: Clickwork and Immaterial Labour

- Dzieza J (2023) AI Is a Lot of Work. The Verge.

- Perrigo B (2023 OpenAI Used Kenyan Workers on Less Than $2 Per Hour to Make ChatGPT Less Toxic. Time.

- Dongus (2018) Refugee Camps as Proving Grounds for New Technologies

- Jones P (2021) Refugees help power machine learning advances at Microsoft, Facebook, and Amazon. Rest of World.

9. Session 14.12.23 - Race and AI

- Benjamin R (2019) Race After Technology: 49-76

- Katz, Y (2020) Artificial Whiteness: Politics and Ideology in Artificial Intelligence. New York: Columbia University Press, 2020: 153-182

Further reading

- Dhaliwal RS (2022) The Cyber-Homunculus: On Race and Labor in Plans for Computation. Configurations, vol. 30 no. 4, 2022, p. 377-409. Project MUSE,

Further readings on class - Eubanks V (2018) Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor. St. Martin’s Press

10. Session 21.12.23 - Predictive Policing and Government Surveillance

- Guariglia M (2020) Technology Can’t Predict Crime, It Can Only Weaponize Proximity to Policing. Electronic Frontier Foundation.

- Schwerzmann K (2021) Abolish! Against the Use of Risk Assessment Algorithms at Sentencing in the US Criminal Justice System. Philosophy and Technology 1:1-22.

Further Reading:

- Wang J (2018) Carceral Capitalism. Semiotext(e).

- Film: Minority Report

Social Credit System - Cho E (2020) The Social Credit System: Not Just Another Chinese Idiosyncrasy. Journal of Public and International Affairs.

- Hmaid A (2019) "The" Social Credit System. Talk at 33C3.

11. Session 11.1.24 - Deep Fakes and the Political Dimension of AI

- Weatherbed J & Sato M (2023) Why won’t TikTok confirm the Bold Glamour filter is AI?. The Verge.

- Pawelec M (2021) Deepfakes and Democracy (Theory): How Synthetic Audio‐Visual Media for Disinformation and Hate Speech Threaten Core Democratic Functions. Digital Society 1 (19):

- https://deepfakes.virtuality.mit.edu/learning-goals/

Further Reading

- Offert F (2023) On the Concept of History (in Foundation Models)

12. Session 18.1.23 - The Ecological Cost of AI & Explainability

- van Wynsberghe A (2021) Sustainable AI: AI for sustainability and the sustainability of AI. AI and Ethics (2021) 1:213–218

- Thompson et al (2021) Deep Learning's Diminishing Returns. IEEE Spectrum.

- Luccioni S (2023) The mounting human and environmental costs of generative AI. Ars Technica.L

- Bornstein (2016) Is Artificial Intelligence Permanently Inscrutable? Nautilus

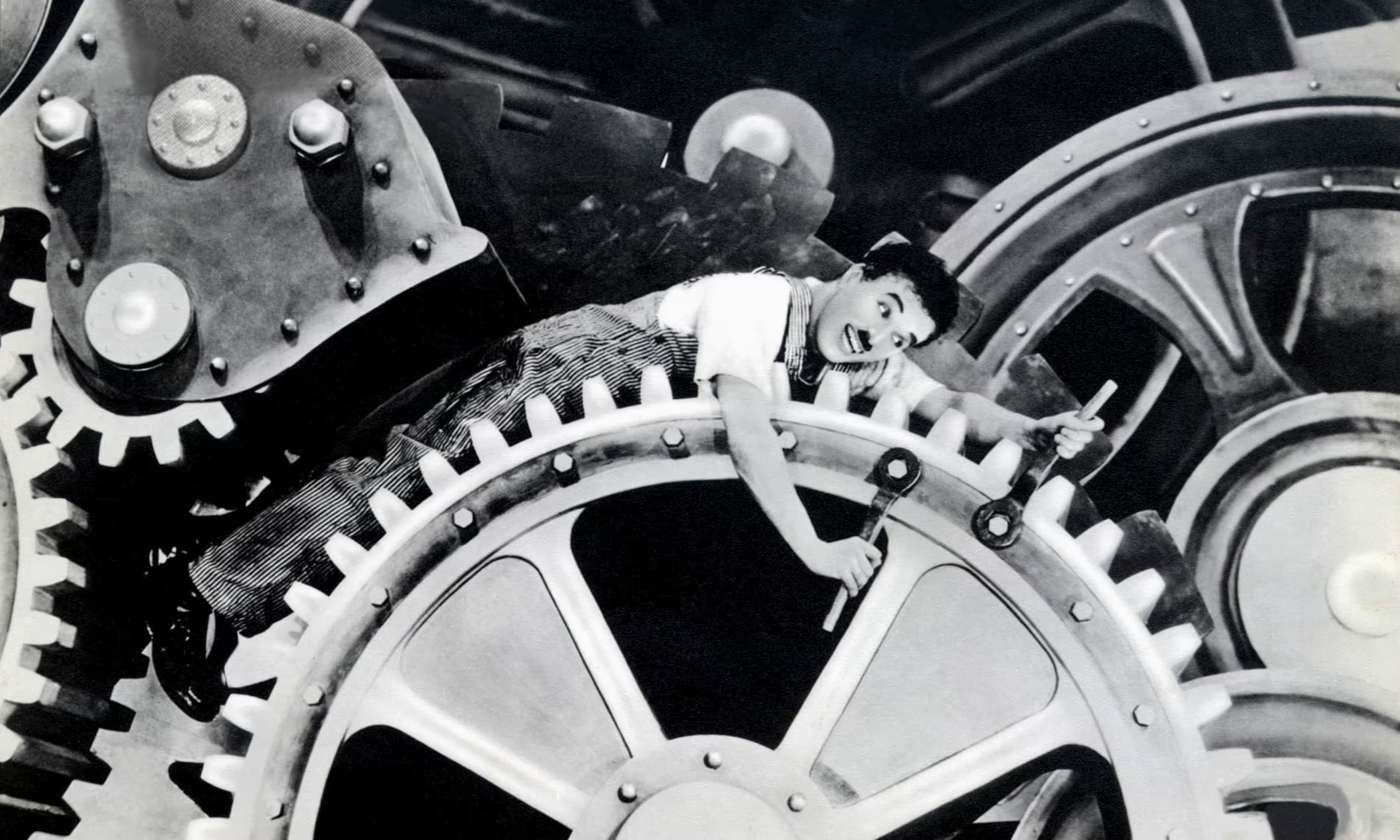

13. Session 25.1.24 - Future of Work and Moravec’s Paradox

- Grünberg M (2023) Lang Lebe der Bricoleur

- Taylor A (2018) The Automation Charade. Logic Magazine

- Moravec H (1988) Mind Childen: The Future of Robot and Human Intelligence. Harvard University Press: 15-22.

- Mcquillan D (2022) Resisting AI. An Anti-fascist Approach to Artificial Intelligence. Bristol University Press: 51-54

14. Session 1.2.24 - Resisting AI

- Mcquillan D (2022) Resisting AI. An Anti-fascist Approach to Artificial Intelligence. Bristol University Press: 135-148.